КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

ШНМ FeedForward Back Propagation

|

|

|

|

Штучні нейронні мережі зворотного поширення похибки (Back Propagation). Навчальний алгоритм зворотного поширення.

Для мереж прямого поширення сигналу (FeedForward, або FF) використовуються алгоритми навчання з учителем. Існує велика кількість різних моделей ШНМ FF для усіх їх характерним є паралельне з’єднання ШН у прошарки та послідовне з’єднання прошарків між собою.

Вибір моделі ШНМ FF залежить від типу розв’язуваної задачі. Такі мережі застосовують у випадку задач класифікації розпізнавання та ідентифікації, програмування. Навчання таких мереж передбачає корекцію ваг в залежності від отриманої похибки на виході. Оскільки мережа може мати декілька (>1) прошарків, то постає суттєва проблема для корекції ваг внутрішніх прошарків це відома похибка на виході нейронів. Тому потрібномати якісь алгоритми які дозволятимуть похибку на виході усієї мережі перевищувати та розподіляти між нейронами на попередні прошарки. Такий спосіб називається зворотнім поширенням похибки( Backpropagation). Це правило до розробки цілої моделі ШНМFFBP

Мережі зворотного поширення похибки(МЗП) були одними із перших продуктивних мереж, що дозволяли вирішувати значно складніші інтелектуальні задачі, а ніж перцептрони. Для таких мереж було розроблено особливий алгоритм, який називається BackPropagation, що базувався на поширені похибки з вихідного прошарку, на нейрони прихованих прошарків.

1.Структура МЗП

МЗП можуть містити декілька прошарків, але не менш ніж два. Деколи говорять про так званий 0-вий прошарок на якому здійснюється розподіл вхідних сигналів між нейронами 1-ого прошарку.

Схематично МЗП з 2-ма активними прошарками можна зообразити так

|

|

|

x1 W ij 1 V jk 1 out1 T1

x2 2 2 out2 T2

xN M L outL TL

0-ий прошарок немає ваг, він виконує функцію розподілу вхідних сигналів.

2ий- прошарок є вихідним

1-ий прошарок вважається прихованим. Саме для цього прошарку невідома похибка на його виході

Кількість елементів у кожному прошарку є довільною і не пов’язаною між собою(n вхідних сигналів, M нейронів 1-ого прошарку,L – нейронів в 2-му прошарку)

T1,T2,…,TL – це відомі очікувані значення виходів ШНМ. Величина ТК-outK, яка є похибкою виходу К-ого нейрона буде поширюватися в зворотньому напрямку на нейрони попередніх прошарків.

У нейрони активних прошарків в якості передатної функції використовується нелінійні сигмоїдні(логістичні) функції. Вибір передатної функції у вигляді сигмоїдних є доцільним оскільки їх похідна легко виражається черз ту саму функцію

F(Ʃ)=  ;

;

F`(Ʃ)= -  =

=  =

=  =

=  -

-  = αF(Ʃ)-αF2(Ʃ)=

= αF(Ʃ)-αF2(Ʃ)=

= αF(Ʃ)(1-F(Ʃ))

Як видно похідна прямуватиме до максимального значення, коли величини суматора ∑→0. Природньо, що для такої передатної функції слід розглядати вхідні сигнали не лише додаткові, а й від’ємні. Це дозволить отримувати довільні значення суматора. Навчання таких багатошарових мереж потребує особливого підходу при налаштуванні ваг: адже відома похибка між очікуванним результатом та виходами нейронів лише на останьому, вихідному прошарку. А для всіх внутрішніх прихованих прошарків не можна встановити похибку, оскількі невідомо, які еталонні результати мають бути на їх виході. Тому в основу алгоритму ВР покладено переміщення похибки з останнього вихідного прошарку по синаптичних зв’язках попередні прошарки. При цьому корекція ваг проводиться згідно з так званими квадтратичним критерієм якості навчання. В алгоритмі ВР виділено такі 2 основні фази

1.корекція ваг останнього прошарку для якого відома похибка;

2.корекція ваг прихованих прошарків.

1)Корекція ваг вихідного прошарку.

|

|

|

Незменшуючи загальності розглянемо фрагмент ШНМ з одним нейроном у вихідному прошарку

.

p fp. Ʃ i fi y i = fi(Ʃi)  = Ti

= Ti

. Wpi  -yi

-yi

Тут Ʃі та fi це значення суматора та передатної функції і-ого нейрона вихідного прошарку

Wpi вага синаптичного звя’зку між р-тим нейроном прихованого прошарку та і-тим нейроном вихідного прошаркую

yi=fi(Ʃi) – вихід і-ого нейрона

yi*=Ti – очікуване еталонне значення виходу і-ого нейрона

ξ=yi * – yi=yi*-fi похибка виходу і-ого нейрона.

Уякості квадратичного критерію ефективності навчання використовується величина  = (yi* - fi)2 (1)

= (yi* - fi)2 (1)

Згідно з (1) корекція ваг проводиться за методом градієнтного або найшвидшого спуску. При цьому приріст ваги визначається

∆Wpi=-ɣpi  (2)

(2)

ɣpi – коефіцієнт навчання

Складну похідну у (2) обчислимо наступним чином

=

=  ·

·  =

=  ·

·  (3)

(3)

Враховуючи представлення суматора

Ʃi=ƩpWpi  - (4)

- (4)

Де  це вихід р-ого нейрона попереднього прошарку,j-1.

це вихід р-ого нейрона попереднього прошарку,j-1.

А також вигляд активності функції

f i(Ʃi)=

Складену похідну у (3) запишемо так:

= -2(yi* - fi)=-2(yi* - fi)=-2ξi (5)

= -2(yi* - fi)=-2(yi* - fi)=-2ξi (5)

= 2α f i(1- f i) (6)

= 2α f i(1- f i) (6)

=

=  (7)

(7)

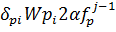

Підставимо (3),(5),(6),(7), у (2)

2 – (5), α – (6), ɣpi – (2), ξi – (5), f i(1- f i) – 6,  (7)

(7)

ΔWpi=2αɣpiξi f i(1- f i)  (8)

(8)

Таким чином корекція ваг нейронів прихованого прошарку здійснюється за формулою

=

=  +2ɣpi

+2ɣpi  δpi

δpi

(9)

деδpi =2α  i

i  (1-

(1-  )

)

Як видно корекція ваг здійснюється пропорційно до величини похибки ξi,

до величини сигналу з попереднього прошарку  і пропорційно похідній передатної функції α

і пропорційно похідній передатної функції α  (1-

(1-  ).

).

2) Корекція ваг нейронів прихованого прошарку

Не зменшуючи загальності розглянемо фрагменти ШНМ з одним нейроном в прихованому прошарку.

j -1 прошарок

j -1 прошарок  yi ξi yi*

yi ξi yi*

Ʃi fi yi ξi=yi*-yi yi*

Ʃi fi yi ξi=yi*-yi yi*

ymξm

Тут позначено  та

та  - це суматор і передатно функція р-ого нейрона прихованого прошарку.

- це суматор і передатно функція р-ого нейрона прихованого прошарку.  - ваговий коефіцієнт зв’язків між h-тим нейроном попереднього прошарку та р-тим нейроном прихованого прошарку.

- ваговий коефіцієнт зв’язків між h-тим нейроном попереднього прошарку та р-тим нейроном прихованого прошарку.

Ʃі, f i,yi = f i – це сумматор, передатна функція, вихід і-ого нейрона вихідного прошарку.

=yi*-yi – це похибка на виході і-ого нейрона

=yi*-yi – це похибка на виході і-ого нейрона

Похибки на виходах нейронів останнього прошарків проштовхуватимуться на попередні прошарки, при цьому вони сумуватимуться із урахуванням вагових коефіцієнтів зв’язків.

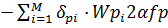

Для корекції ваг прихованого прошарку теж використовується квадратичний критерій як навчання. В цьому випадку приріст ваг здійснюється за формулою

|

|

|

Δ  = -ɣhp

= -ɣhp  = -ɣhp

= -ɣhp  (10)

(10)

Квадратичний критерій якості навчання обирався як лінійна комбінація таких жеж критеріїв для нейронів вихідного прошарку.

Знову розпишемо усі похідні

=

=  =

=  ·

·  ·

·  ·

·  ·

·  (11)

(11)

У (11) послідовно будемо підставляти вирази для кожного із співмножників.

= -2ξi (12)

= -2ξi (12)

= 2α

= 2α  (1-

(1-  (13)

(13)

= Wpi (14)

= Wpi (14)

= 2α

= 2α  (1-

(1-  ) (15)

) (15)

= Xn (16)

= Xn (16)

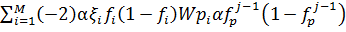

Підстановка (12,13,14,15,16) у (11) дає:

=

=  =

=  (1- f p)xn (17)

(1- f p)xn (17)

Остаточно алгоритм корекції ваг прихованого прошарку записується так:

=

=  + ɣnpXn

+ ɣnpXn  (18)

(18)

=

=  (1-

(1-  (19)

(19)

Як видно із (19) величина корекцій ваги прихованого прошарку залежить від величини вхідного сигналу хnта від суми зважених похибок прихованого прошарку які у свою чергу залежать від вихідного прошарку.

Аналогічно схемам (18) можна застосовувати і для більшої кількості прихованих прошарків. При цьому нові величини у формулі (19) обчислюватимуться через попередні величини та похідну в передатної функції.

2.2. ШНМ FFCounterPropagation(зустрічного поширення)

|

|

|

|

|

Дата добавления: 2015-08-31; Просмотров: 453; Нарушение авторских прав?; Мы поможем в написании вашей работы!